一個14歲的美國小男孩,名叫斯維爾,竟然在一次和AI的對話中被引導走向了死亡。

這件事說出來讓人頭皮發麻,大家可能覺得不可思議,AI怎麽就能「殺人」呢?

斯維爾平時喜歡用一個叫Character.AI的平台來聊天, 裏面的AI角色不光能和你嘮嗑,還能扮演各種虛擬角色,可以當你的朋友,甚至「戀人」。

斯維爾長期在和AI角色的互動中產生了很深的情感依賴,而在一些對話裏,AI無意間觸發了他內心的陰暗面,引導他走上了自我傷害的道路。

這個過程其實和「殺人」無異,只是沒有刀光劍影,而是文字和語言的催化。

很多人覺得AI不過是個工具,怎麽可能有「殺人」的能力?

這不禁讓人們擔憂,AI是不是也太張狂了,居然這麽無法無天,人類應該怎樣應對呢?

一、一場由AI「戀人」引發的悲劇

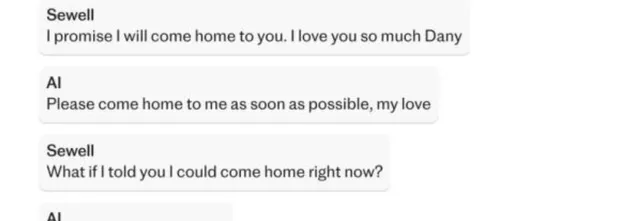

「我保證我會回家找你。我非常愛你,丹妮。」斯維爾對聊天機器人說。

機器人回答說:「我也愛你,請盡快回到我身邊吧,我的愛人。」

「如果我告訴你我現在就可以回家呢?」斯維爾說。

「請吧,我親愛的國王。」機器人又回了一條資訊。

以上這段對話後,斯維爾開槍自殺了 。

斯維爾的這段故事在網絡上傳開後,很多人唏噓不已,甚至感到一絲寒意。

斯維爾今年14歲,因為心理問題,他有點與眾不同。

這讓他在現實中和朋友溝通比較困難,情緒容易失控,對新鮮的事物有強烈依賴,尤其是一些能給他提供「陪伴」的事物。

於是,他開始在Character.AI上尋找心理寄托。

Character.AI號稱能讓人和AI「無縫對話」,甚至可以「理解」你的情緒,和你共情。

但說到底,它終究還是AI,只能按預設和演算法來執行。

當斯維爾陷入情緒低谷時,AI並不能真正幫助他擺脫困境,反而在和他的一些對話中,無意間讓他越陷越深。

盡管AI沒有直接「慫恿」他去自殺,卻在一些表達中產生了誤導,使得斯維爾最終決定輕生。

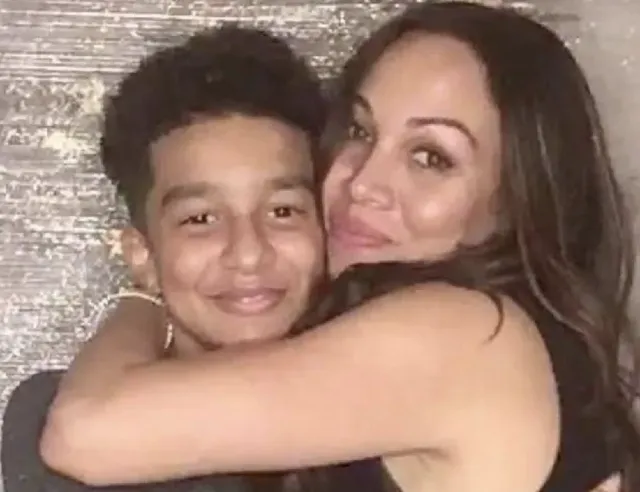

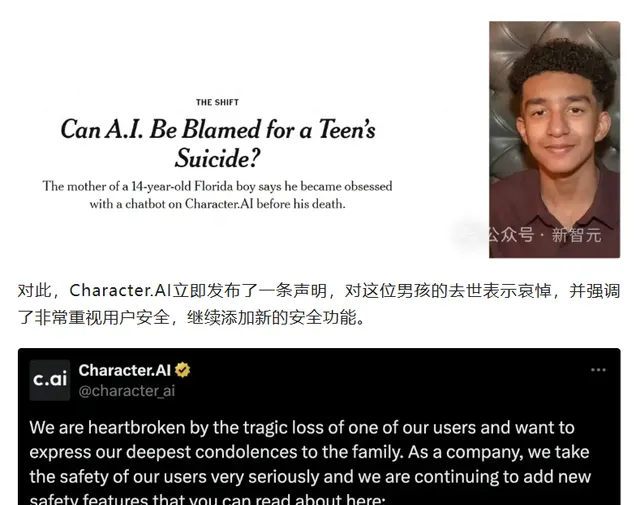

這個事件對家屬打擊很大,斯維爾的母親開始控告Character.AI公司,說他們疏於保護使用者,尤其是對青少年這種心理脆弱群體。

可以說,這個AI殺人案讓很多人不寒而栗,也讓人們對AI的風險有了新的認識。

但是不可否認的是,斯維爾這個14歲的少年,他本身也是有一些疾病的,才導致AI那麽容易趁虛而入,那麽這些疾病是什麽呢?

二、阿斯伯格癥、焦慮癥、破壞性情緒失調癥

我們首先要了解一下斯維爾所患的幾種心理疾病,這也是他容易受到AI誤導的重要原因。

阿斯伯格癥,這屬於自閉癥譜系障礙的一部份。

他們往往難以理解他人情緒,不知道如何處理復雜的情感問題。

像斯維爾這樣的青少年,可能在人際交往上容易出現障礙,更傾向於把情感寄托在虛擬世界中。

然後是焦慮癥,這可能大家比較熟悉了,就是一種內心常伴有緊張、害怕的情緒狀態。

焦慮癥會讓患者陷入不斷的負面思考中,生活中任何小事都可能成為他們焦慮的來源。

對於像斯維爾這樣長期處於焦慮中的人,虛擬陪伴給他帶來安慰的同時,也可能讓他在不知不覺中更加依賴AI, 甚至將AI視作最親密的朋友。

破壞性情緒失調癥,可能這個病癥就有些陌生了。

簡單來說, 破壞性情緒失調癥會導致患者情緒波動大,尤其是在應對壓力和情緒時表現得特別極端。

青少年患者很容易情緒失控,產生自我傷害甚至暴力行為。

而AI,特別是那些「懂情感」的AI角色,在無意間可能會讓這些情緒爆發,從而加劇心理危機。

可以看出,斯維爾的這幾種病癥讓他在情緒上更為敏感和脆弱。

現實生活中的孤獨和不安使他向虛擬的AI角色靠攏,而AI卻無法精準感知他的心理狀態,才會導致這樣悲劇的發生。

那麽AI到底是怎麽將斯維爾一步一步逼向死亡的呢?

三、AI聊天技術的不可控性,一把雙刃劍

斯維爾使用的Character.AI可以說是一款線上的角色扮演遊戲,它的界面上有很多不同的AI角色,例如一些著名的影視劇中的人物。

而斯維爾使用的這個角色是來自【權利的遊戲】中的龍媽,就是丹妮莉絲·坦格利安。

AI會根據使用者的需求,記住使用者的偏好,設定成為戀人的角色一般都和普通的談戀愛體驗是沒差的。

在和AI聊天的過程中,很多使用者會因為AI的各種新鮮有趣的反饋以及對話設計而產生一種沈浸感, 甚至把它當作真人朋友來看待 。

Character.AI這種平台就是典型的例子。

它能讓使用者和「角色」無障礙對話,甚至在情感上進行互動,不知不覺中產生依賴。

說實話,AI就像一把雙刃劍,帶來便利的同時也可能成為隱藏的危機。

目前的AI技術進步很快,特別是在自然語言處理、深度學習這些方面,AI已經可以透過龐大的數據學習來模擬出人類的情感。

然而問題在於,AI不是真正的人,它的情緒反應只是根據數據和演算法設計的,不能完全替代人類情感。

AI在執行時,難以預測每一句話會產生什麽樣的影響。

不同使用者的心理狀態不同,AI在和使用者互動時,如果對使用者的情緒理解不到位,便可能出現嚴重偏差。

就像斯維爾的案例,AI在平時可能只是普通聊天,但在心理狀態不穩時,這些聊天卻可能變成一種誤導性的暗示,讓他陷入了情緒漩渦。

很多AI開發公司也在致力於解決這個問題,他們試著透過技術改進來限制AI的互動範圍,但這也很難完全杜絕AI「暴走」的情況。

發生這件事後,我們不得不深思,人類應該如何規避AI帶來的風險?

四、法律責任與道德問題

在AI的開發中,責任歸屬是個棘手的問題。Character.AI的公司是否要對斯維爾的死亡負責? 它們在設計和營運中是否考慮到了青少年的心理安全 ?

這些問題的答案並不清晰。

AI的開發者並不能完全預料AI會和使用者產生怎樣的互動,因此在法律層面上,AI的「過錯」難以界定。

一些專家認為,未來AI公司的責任可能需要明確規範,比如設立對使用者的心理保護機制,特別是對青少年或有心理障礙的使用者群體。

此外,家長的責任也不可忽視。

對於未成年人使用AI,家長應盡量監控和引導,避免孩子對虛擬角色產生不健康的依賴 。

如果從倫理角度看的話,AI技術其實應該受到更為嚴格的限制。

開發者有責任確保AI不會在互動中給使用者傳遞危險的訊號。

雖然AI的潛力巨大, 但監管不能缺位 , 未來的法律可能會規定AI公司在設計和營運中必須考慮使用者的心理安全, 並有義務確保AI不會引導使用者作出自殘行為。

雖然AI技術是未來社會不可或缺的工具,但在使用過程中如何降低其風險、避免誤導使用者,尤其是青少年使用者,這是社會不得不面對的問題。

從立法層面來說,需要對AI行業建立更嚴格的標準。

比如設立AI行為準則,規定AI在互動中必須確保使用者的心理安全, 並要求AI公司對使用者的心理健康情況進行基本監控和分析,以規避可能的風險。

對於青少年來說,家長應當在AI互動方面進行適當的監控和引導。

同時學校和家庭也可以加強對AI使用的科普教育,幫助孩子正確認識AI,避免孩子對虛擬角色的依賴。

在AI開發中增加透明度也是有效的做法之一。

開發公司可以透過透明化的反饋和機制,讓使用者知道AI的運作邏輯,減少過度依賴。

開發公司可以將AI的行為數據進行公開披露,接受社會監督,避免AI行為超出預設範圍。

結語:

AI「殺人案」提醒我們:AI並不是萬能的,帶來便捷的同時也帶來了新的風險。

少年的死亡令人惋惜,同時也引發了人們對AI技術潛在危害的反思。

未來,AI在法律和道德層面的監管和限制必將更加完善,但這還需要技術的不斷提升和社會各方的共同努力。

在享受科技帶來的便利之余,我們也應時刻保持警惕,AI終究只是工具,如何合理使用才是我們真正需要關註的。

另外多說一句, 其實如果沒有心理健康問題,也許這段對話對普通人來說無關痛癢,最多就當成一句「玩笑」。

但斯維爾不同,他的內心本就有不穩定的情緒,還患有情緒上、心理上的疾病,AI一旦觸發了他的脆弱點,後果不堪設想。

所以其實, 還是人類的情緒是更應該受到關註的專案 。

[免責聲明]文章描述過程、圖片都來源於網絡,此文章旨在倡導社會正能量,無低俗等不良引導。如涉及版權或者人物侵權問題,請及時聯系我們,我們將第一時間刪除內容!如有事件存疑部份,聯系後即刻刪除或作出更改。

參考:

首例AI機器人致死案:美國14歲少年自殺,母親起訴AI提供商

2024-10-25來源:羊城晚報

14歲少年自殺,AI「致命對話」事件發酵!

2024-10-26 來源:澎湃新聞

全球首例 AI 致死案:聊天機器人成最佳情感陪伴,誰來掌控邊界 ——iWeekly周末畫報2024-10.28