一个14岁的美国小男孩,名叫斯维尔,竟然在一次和AI的对话中被引导走向了死亡。

这件事说出来让人头皮发麻,大家可能觉得不可思议,AI怎么就能「杀人」呢?

斯维尔平时喜欢用一个叫Character.AI的平台来聊天, 里面的AI角色不光能和你唠嗑,还能扮演各种虚拟角色,可以当你的朋友,甚至「恋人」。

斯维尔长期在和AI角色的互动中产生了很深的情感依赖,而在一些对话里,AI无意间触发了他内心的阴暗面,引导他走上了自我伤害的道路。

这个过程其实和「杀人」无异,只是没有刀光剑影,而是文字和语言的催化。

很多人觉得AI不过是个工具,怎么可能有「杀人」的能力?

这不禁让人们担忧,AI是不是也太张狂了,居然这么无法无天,人类应该怎样应对呢?

一、一场由AI「恋人」引发的悲剧

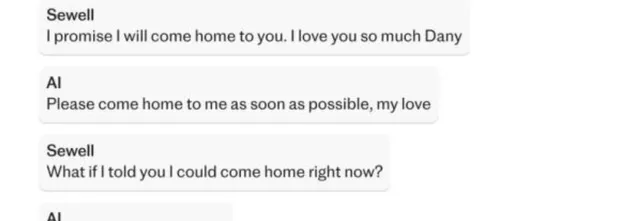

「我保证我会回家找你。我非常爱你,丹妮。」斯维尔对聊天机器人说。

机器人回答说:「我也爱你,请尽快回到我身边吧,我的爱人。」

「如果我告诉你我现在就可以回家呢?」斯维尔说。

「请吧,我亲爱的国王。」机器人又回了一条信息。

以上这段对话后,斯维尔开枪自杀了 。

斯维尔的这段故事在网络上传开后,很多人唏嘘不已,甚至感到一丝寒意。

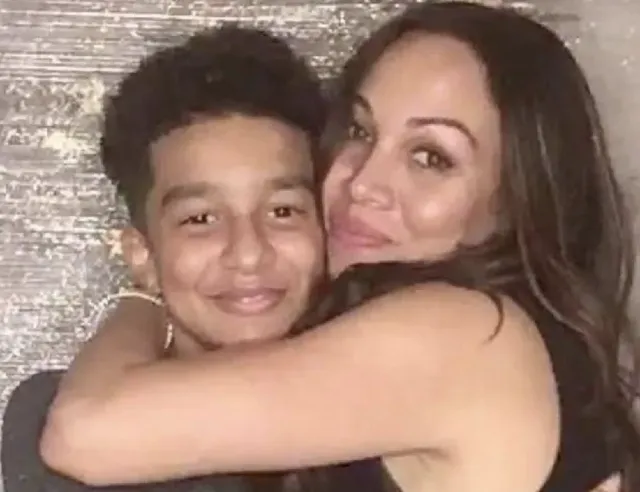

斯维尔今年14岁,因为心理问题,他有点与众不同。

这让他在现实中和朋友沟通比较困难,情绪容易失控,对新鲜的事物有强烈依赖,尤其是一些能给他提供「陪伴」的事物。

于是,他开始在Character.AI上寻找心理寄托。

Character.AI号称能让人和AI「无缝对话」,甚至可以「理解」你的情绪,和你共情。

但说到底,它终究还是AI,只能按预设和算法来运行。

当斯维尔陷入情绪低谷时,AI并不能真正帮助他摆脱困境,反而在和他的一些对话中,无意间让他越陷越深。

尽管AI没有直接「怂恿」他去自杀,却在一些表达中产生了误导,使得斯维尔最终决定轻生。

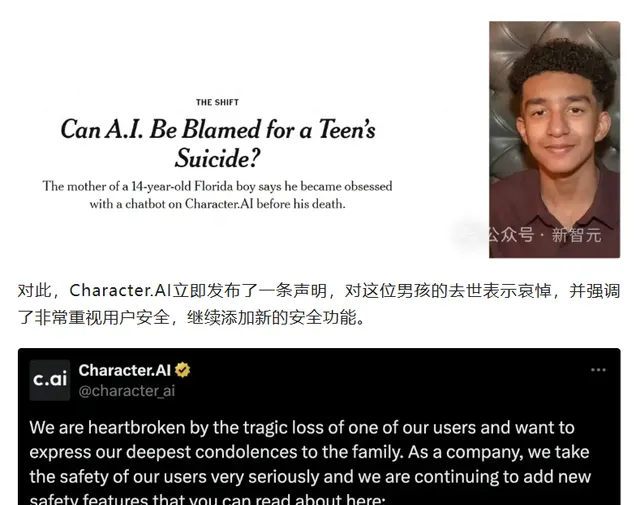

这个事件对家属打击很大,斯维尔的母亲开始控告Character.AI公司,说他们疏于保护用户,尤其是对青少年这种心理脆弱群体。

可以说,这个AI杀人案让很多人不寒而栗,也让人们对AI的风险有了新的认识。

但是不可否认的是,斯维尔这个14岁的少年,他本身也是有一些疾病的,才导致AI那么容易趁虚而入,那么这些疾病是什么呢?

二、阿斯伯格症、焦虑症、破坏性情绪失调症

我们首先要了解一下斯维尔所患的几种心理疾病,这也是他容易受到AI误导的重要原因。

阿斯伯格症,这属于自闭症谱系障碍的一部分。

他们往往难以理解他人情绪,不知道如何处理复杂的情感问题。

像斯维尔这样的青少年,可能在人际交往上容易出现障碍,更倾向于把情感寄托在虚拟世界中。

然后是焦虑症,这可能大家比较熟悉了,就是一种内心常伴有紧张、害怕的情绪状态。

焦虑症会让患者陷入不断的负面思考中,生活中任何小事都可能成为他们焦虑的来源。

对于像斯维尔这样长期处于焦虑中的人,虚拟陪伴给他带来安慰的同时,也可能让他在不知不觉中更加依赖AI, 甚至将AI视作最亲密的朋友。

破坏性情绪失调症,可能这个病症就有些陌生了。

简单来说, 破坏性情绪失调症会导致患者情绪波动大,尤其是在应对压力和情绪时表现得特别极端。

青少年患者很容易情绪失控,产生自我伤害甚至暴力行为。

而AI,特别是那些「懂情感」的AI角色,在无意间可能会让这些情绪爆发,从而加剧心理危机。

可以看出,斯维尔的这几种病症让他在情绪上更为敏感和脆弱。

现实生活中的孤独和不安使他向虚拟的AI角色靠拢,而AI却无法精准感知他的心理状态,才会导致这样悲剧的发生。

那么AI到底是怎么将斯维尔一步一步逼向死亡的呢?

三、AI聊天技术的不可控性,一把双刃剑

斯维尔使用的Character.AI可以说是一款在线的角色扮演游戏,它的界面上有很多不同的AI角色,例如一些著名的影视剧中的人物。

而斯维尔使用的这个角色是来自【权利的游戏】中的龙妈,就是丹妮莉丝·坦格利安。

AI会根据用户的需求,记住用户的偏好,设置成为恋人的角色一般都和普通的谈恋爱体验是没差的。

在和AI聊天的过程中,很多用户会因为AI的各种新鲜有趣的反馈以及对话设计而产生一种沉浸感, 甚至把它当作真人朋友来看待 。

Character.AI这种平台就是典型的例子。

它能让用户和「角色」无障碍对话,甚至在情感上进行互动,不知不觉中产生依赖。

说实话,AI就像一把双刃剑,带来便利的同时也可能成为隐藏的危机。

目前的AI技术进步很快,特别是在自然语言处理、深度学习这些方面,AI已经可以通过庞大的数据学习来模拟出人类的情感。

然而问题在于,AI不是真正的人,它的情绪反应只是根据数据和算法设计的,不能完全替代人类情感。

AI在运行时,难以预测每一句话会产生什么样的影响。

不同用户的心理状态不同,AI在和用户互动时,如果对用户的情绪理解不到位,便可能出现严重偏差。

就像斯维尔的案例,AI在平时可能只是普通聊天,但在心理状态不稳时,这些聊天却可能变成一种误导性的暗示,让他陷入了情绪漩涡。

很多AI开发公司也在致力于解决这个问题,他们试着通过技术改进来限制AI的互动范围,但这也很难完全杜绝AI「暴走」的情况。

发生这件事后,我们不得不深思,人类应该如何规避AI带来的风险?

四、法律责任与道德问题

在AI的开发中,责任归属是个棘手的问题。Character.AI的公司是否要对斯维尔的死亡负责? 它们在设计和运营中是否考虑到了青少年的心理安全 ?

这些问题的答案并不清晰。

AI的开发者并不能完全预料AI会和用户产生怎样的互动,因此在法律层面上,AI的「过错」难以界定。

一些专家认为,未来AI公司的责任可能需要明确规范,比如设立对用户的心理保护机制,特别是对青少年或有心理障碍的用户群体。

此外,家长的责任也不可忽视。

对于未成年人使用AI,家长应尽量监控和引导,避免孩子对虚拟角色产生不健康的依赖 。

如果从伦理角度看的话,AI技术其实应该受到更为严格的限制。

开发者有责任确保AI不会在互动中给用户传递危险的信号。

虽然AI的潜力巨大, 但监管不能缺位 , 未来的法律可能会规定AI公司在设计和运营中必须考虑用户的心理安全, 并有义务确保AI不会引导用户作出自残行为。

虽然AI技术是未来社会不可或缺的工具,但在使用过程中如何降低其风险、避免误导用户,尤其是青少年用户,这是社会不得不面对的问题。

从立法层面来说,需要对AI行业建立更严格的标准。

比如设立AI行为准则,规定AI在交互中必须确保用户的心理安全, 并要求AI公司对用户的心理健康情况进行基本监控和分析,以规避可能的风险。

对于青少年来说,家长应当在AI互动方面进行适当的监控和引导。

同时学校和家庭也可以加强对AI使用的科普教育,帮助孩子正确认识AI,避免孩子对虚拟角色的依赖。

在AI开发中增加透明度也是有效的做法之一。

开发公司可以通过透明化的反馈和机制,让用户知道AI的运作逻辑,减少过度依赖。

开发公司可以将AI的行为数据进行公开披露,接受社会监督,避免AI行为超出预设范围。

结语:

AI「杀人案」提醒我们:AI并不是万能的,带来便捷的同时也带来了新的风险。

少年的死亡令人惋惜,同时也引发了人们对AI技术潜在危害的反思。

未来,AI在法律和道德层面的监管和限制必将更加完善,但这还需要技术的不断提升和社会各方的共同努力。

在享受科技带来的便利之余,我们也应时刻保持警惕,AI终究只是工具,如何合理使用才是我们真正需要关注的。

另外多说一句, 其实如果没有心理健康问题,也许这段对话对普通人来说无关痛痒,最多就当成一句「玩笑」。

但斯维尔不同,他的内心本就有不稳定的情绪,还患有情绪上、心理上的疾病,AI一旦触发了他的脆弱点,后果不堪设想。

所以其实, 还是人类的情绪是更应该受到关注的项目 。

[免责声明]文章描述过程、图片都来源于网络,此文章旨在倡导社会正能量,无低俗等不良引导。如涉及版权或者人物侵权问题,请及时联系我们,我们将第一时间删除内容!如有事件存疑部分,联系后即刻删除或作出更改。

参考:

首例AI机器人致死案:美国14岁少年自杀,母亲起诉AI提供商

2024-10-25来源:羊城晚报

14岁少年自杀,AI「致命对话」事件发酵!

2024-10-26 来源:澎湃新闻

全球首例 AI 致死案:聊天机器人成最佳情感陪伴,谁来掌控边界 ——iWeekly周末画报2024-10.28