再次被某些韓男的騷操作震驚!

8月底,鬧得沸沸揚揚的南韓N號房醜聞事件羊已經罵過了。

這次又出現同樣惡劣的性犯罪事件:

一些韓男利用AI把女生臉部摳圖,制造色情內容上傳到網站提供瀏覽瘋狂撈錢,堪比N號房事件2.0。

這個色情網站的覆蓋率有多嚇人?

據爆料者統計,5000w人口的南韓,就有40w人註冊會員,其中有70%的瀏覽使用者還是青少年,這次的調查更是涉及到500多所學校。

細思極恐…

圖源:關於這件事的新聞報道r

換句話說,這麽高的使用者覆蓋率說明這些不法分子的惡行已經侵入到這些女性受害者的熟人社交圈層。

而周圍熟人作案,又進一步催熟了這種情色網站的擴張。

南韓甚至有個專門詞匯叫做「지인능욕」(熟人羞辱)——在聊天群分享女性熟人照片,號召其他男性對她進行性羞辱。

更令人憤恨的是,一些兒童也經AI換臉後成為情色受害者群體。

在這些大量的女性受害者中,有女生受害者表示自己不僅被曝光私密,還收到了敲詐勒索。

熱搜直接顯示:南韓女孩被逼到全世界求助。

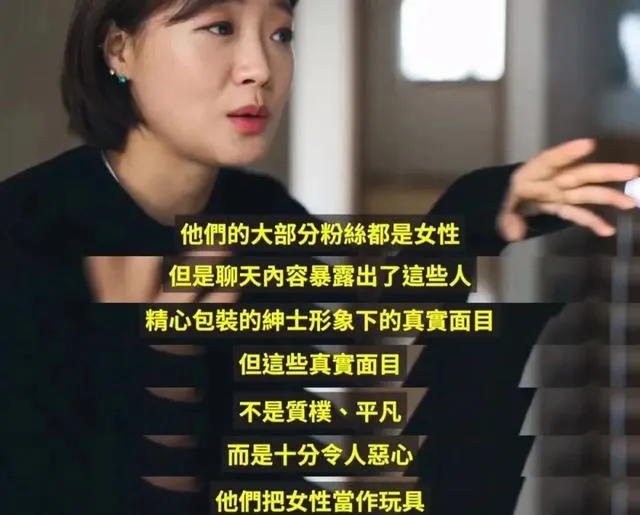

這些不法行為的始作俑者身份的多元化同樣令人震驚,除了一些隔著網線的陰溝裏的蛆蟲外,甚至包括某些男明星。

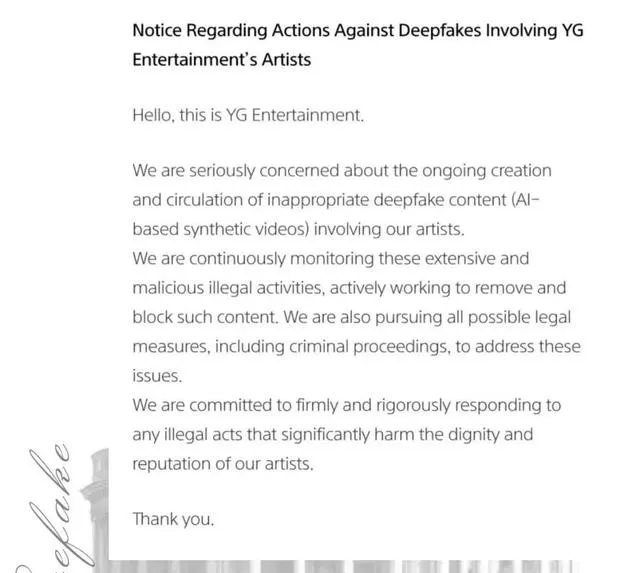

新聞報道中JYP、YG、CUBE等南韓幾大娛樂巨頭的藝人都有沾邊。

他們的不法行為曝光後有的藝人退團,經紀公司也不得不出來釋出聲明,看起來也是實錘得不能再實了。

作惡到如此地步,不僅是身在南韓的女性,整個世界的女孩都在擔憂這件事:

科技在發展,AI在進步,本來都是好事,怎麽到了某些人這裏,就成了專門針對女性作惡的工具了?

今天羊就來具體科普下這次的作案工具Deepfake到底是咋回事,以及在高科技行業工作的女性提供的正確防範方式。

Deepfake被濫用

是懸掛在女性頭上的一把刀

先說說這次令人感到不安的高科技Deepfake到底是個啥?

Deepfake這個詞在學科內指的一般是使用AI技術進行「面部操作」,生產假影片,制造假新聞。

這次被爆出的色情網站telegram上就有兩種此類AI作案工具。

一種工具叫做bot,可以利用AI直接自動將女性受害者照片合成色情圖片影片。

除了bot之外,還有另一種是淩辱房(聊天群,以大學和地區為單位), 和之前被爆出來的N號房類似,顧名思義的爛透了。

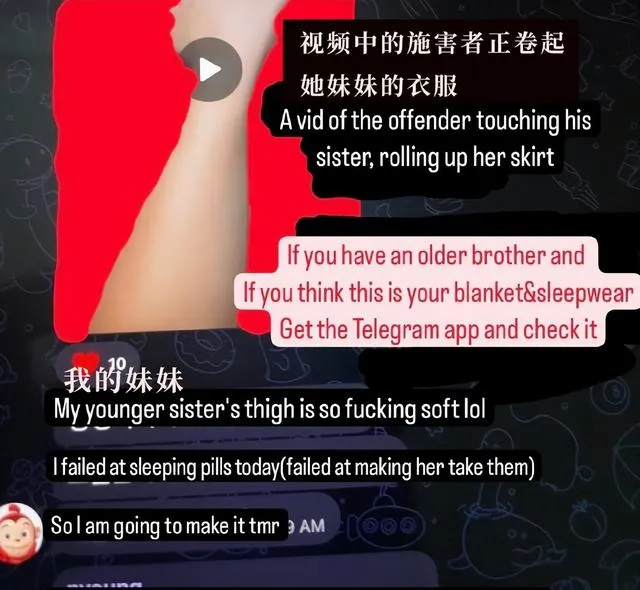

甚至有些照片是在給女性親屬下藥後拍攝的,惡心到想吐又實在是毛骨悚然。

淩辱房群內的男性會故意接近受害者女性,告訴她,她被deepfake並分享了,記錄下她的反應,再向群內傳播,主打一個沈浸式羞辱。

除了圖片影片之外,網站上還提供一些猥褻女孩的群直播。

這種把不知情的素人做成情色圖片供陌生人瀏覽的獵艷有多誇張?

經受害者爆料,其中一個bot的粉絲數量達到了40萬人,僅僅在學生群體中,網站的使用者就很可觀。

韓女根據使用telegram男學生的密度,繪制了共享地圖,紅點覆蓋面密集得令人窒息。

還有爆料者稱,素人網友去南韓街,就有被AI換臉到色情網站的。

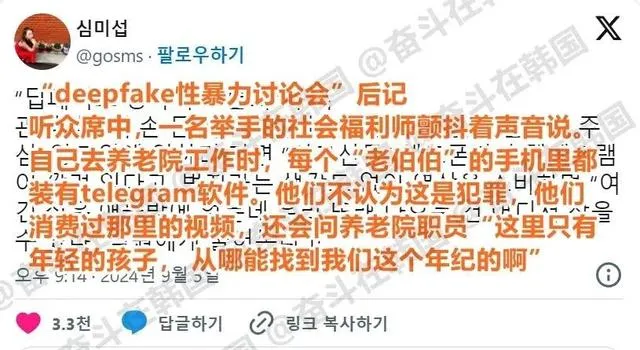

南韓deepfake性犯罪已經滲透至養老院,老人像訂閱報刊一樣日常消費這些被AI惡意生成的情色,呵呵。

@奮鬥在南韓

N號房和 Deepfake本質都是性剝削,但犯罪形式完全不同,Deepfake是利用女孩釋出的照片來AI操作。

也就是說,後者的操作更容易更廣泛,犯罪的門檻更低,女孩子成為受害者也更容易。

同時,比N號房犯罪更可怕的,是利用Deepfake犯罪的人,因為和受害者可以沒有任何關系。

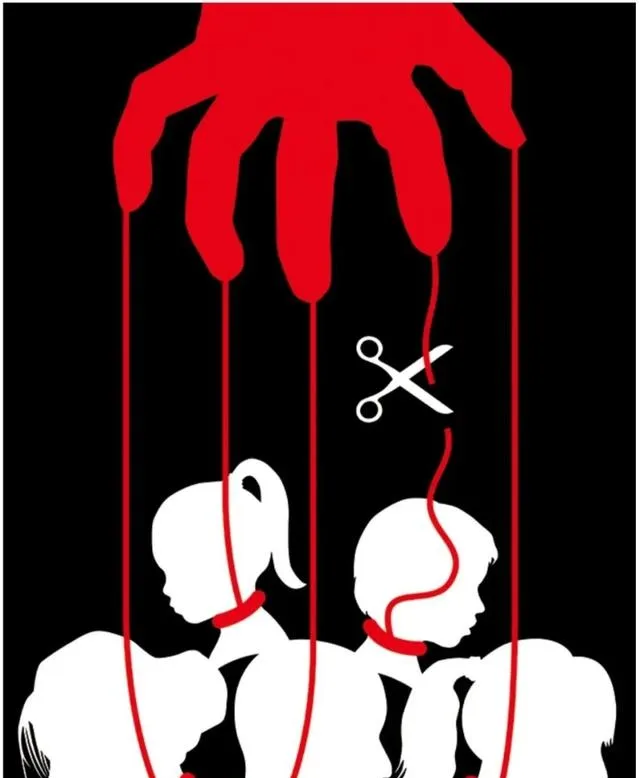

道德借由網線隔開,被人性煽動,再被技術麻木磨滅,在他們犯罪的過程中,受害者最大程度的被物化為犧牲品。

陌生人可以隨機作案,熟人也可以, 尤其是熟人作案,很容易摧毀受害者構建起來的熟人圈層的安全感。

有一些女孩,如我們前面提到的,被周圍的人辨別出來,還收到了敲詐勒索,受到了二次型的暴力傷害。

而不管是被換頭還是被勒索,這些對她們來說都可以是很突然的天降橫禍。

最令人惡心的是,AI換臉不僅傷害女性,還可以給男性免責,把男生的臉換了。

醜聞爆炸後,韓網上有人發帖,「我上初中的兒子會因為AI換臉性犯罪被處罰嗎」。

氣得網友辣評:你寶不是打遊戲當什麽捏臉玩家,他犯罪了哎餵!

明明Deepfake的被濫用是部份韓男在違法,最後卻成為專門針對女性的一把刀。

並且,不僅是在南韓,在美國其他一些地區,也發現了這種技術在情色上的濫用。

AI換頭不是惡作劇

而是犯罪

為啥Deepfake的濫用這次引起全世界範圍內的痛恨?

或許會有人說,問心無愧沒做,不理不就行了?顯然,Deepfake的問題絕非這麽簡單。

在加害者眼中,換臉是無足輕重的玩笑和鬧劇,對受害者而言卻是拖她們進入地獄模式。

「在臉被偷走的同時,女孩們的身份、名譽、私密、尊重也都被偷走了」。

這些被竊取被傷害的女孩,她們並不是一行影像程式碼,一次訂閱數據,而是擁有思想、生活的真實人類。

即使只是被偷取資訊換頭,那些色情內容也足夠令她們痛苦。

其次,Deepfake在情色行業的濫用,本質上就是對女性的性剝削。

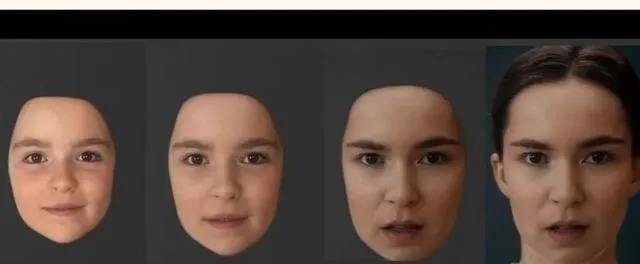

回歸到這個詞出現的最早時期,Deepfake這個詞在學科內指的一般是使用AI技術進行面部操作,生產假影片,制造假新聞。

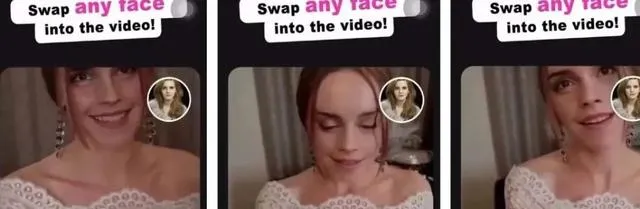

這一概念最早源自一個名為deepfakes的使用者,該使用者在 Reddit上釋出影片,將娛樂明星的臉換到色情影片上,得到了大量關註和轉發。

赫敏被AI換臉後的擦邊影片

也就是說,從一開始,它在色情領域的套用就是違法的。

也有學者把這種因為數碼產品或者互聯網技術的發展對女性造成的傷害稱為「數碼性剝削」。

以N號房和Deepfake為例,數碼性剝削不僅包括偷拍、傳播、情色資料交易等具體行為,還包括在技術層面,全體女性的權益不被制度和規則保護。

幸運的是,我們還有那些堅持為女性權益發聲的科研人員。

就在前幾天,上海外灘大會AI創新賽,中科院工程師張欣怡公開宣布自己會和團隊一起努力攻克Deepfake的演算法。

怎麽攻克?簡單來說就是檢測這個畫面是不是AI合成,類似AI查重。

張欣怡已經承諾會盡快開放針對Deepfake的套用,降低門檻讓所有人免費使用。

她表示:「既然有人用技術造假,那麽我們也要用技術去阻止他們得逞,如果一個人的火把太小,我們就把火把傳給世界的每一個人」。

同為AI技術創作者的女博主也真情實感發聲:我們做AI產品,初衷是想讓社會變得更好,這才是AI的意義。

如果技術能夠提供力量,就永遠有比妥協更好的辦法。

除了針對Deepfake的演算法之外,一些好訊息還在繼續。

據韓聯社9月5日報道,南韓警方已被拘捕南韓一名高中生,後者涉嫌使用Deepfake性暴力犯罪。

最後羊想說,犯錯的人才應該被懲罰,而不是以受害者的退讓為結束。

每一個女孩都是活生生的人,她們不應該被物化和性化,女孩們活著應該發光發亮,而不是被踐踏,被熄滅。

女孩們的生活日常,不該成為情色網站的內容。

就像【N 號房追蹤記--南韓數碼性剝削犯罪記錄】的作者在書中寫道:

「我們要切斷把女性視為漂亮的花朵,最終和性器官畫上等號的父權制和資本主義的紐帶」。

如果科技的進步損害了女性的權益,那麽就應該有人站出來去修改。

只有女性的權益得到保護,人類的科技文明,才是真正的文明進步。