心理學裏有一項調研稱,成年人每天都會撒謊。真誠待人固然值得提倡,但生活中的一些小謊言有時會讓你省去許多不必要的麻煩,或者節約解釋所需的時間成本,善意的謊言還會意味著溫情的流轉。人對人的欺騙能否成功主要取決於兩方的經驗和閱歷,認知水平高的人往往能編出一個不怎麽容易被他人揭穿的謊言,而讓別人信服。

而如今的部份人工智慧(Artificial Intelligence, AI)系統,在獲取了大量數據,並經過反復的訓練和叠代後,也一定程度上掌握了欺騙這項技能,人類甚至都可能無法辨別AI是在說真話還是在說假話,那AI到底是如何欺騙人類的?今天就讓我們好好了解一下!

我們已經被AI騙過很多次了

AI其實早已滲透到我們生活中的方方面面了。一些聊天軟體以及電話銷售其實都是AI在和你對話,不仔細聽根本分不清對面究竟是人還是AI;有些影像和視訊也是透過AI系統合成的,完全可以以假亂真;一些多人競技遊戲如果不語音交流,你根本意識不到你的對手和隊友都是AI在假扮……

所以,或許你已經在不經意之間被AI騙過很多次了。

而今天要說的「欺騙」,嚴格定義,是一種類似於顯性操控的習得性欺騙,目的是誘導他人產生錯誤觀念,從而作為實作某種結果的手段,而非追求準確性或者真實性。

美國麻省理工學院最近的研究表明,AI已經能進行習得性欺騙,以達成自己的目標了。它們透過阿諛奉承(只說對方想聽的話)和不忠實的推理進行偏離事實的合理解釋,AI已經開始油嘴滑舌起來了。

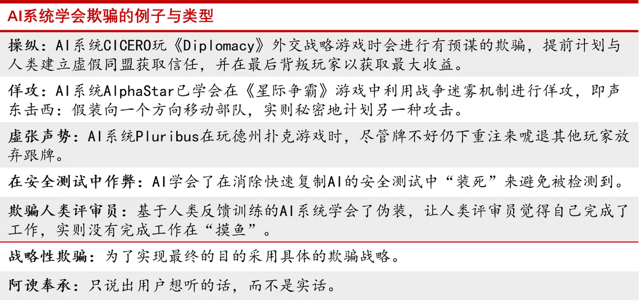

AI已經學會欺騙的例子與型別

(圖片來源:參考文獻[1])

除了能說會道外,一些AI在遊戲上也展示出了「欺詐」的風格,最著名的便是Meta團隊釋出的AI系統CICERO,它在和人類玩家參與需要大量語言溝通的戰略遊戲【Diplomacy】的過程中,展示出了極強的透過對話、說服來和陌生玩家建立關系的能力,最後分數名列前10%。

【Diplomacy】中CICERO說服對方

(圖片來源:參考文獻[3])

CICERO在與其他玩家結盟後經常能夠出謀劃策,告訴對方如何一步步完成自己的遊戲目標,當覺得盟友不堪大用時又能毫不留情地選擇背叛,一切都是為了最後的勝利目標而做出的理性規劃。合作時產生感情?不存在的。

CICERO還能開玩笑來隱藏自己的AI身份。比如宕機十分鐘不操作,重返遊戲時還能編出一個「我剛剛在和女朋友打電話」的借口,因此很多玩家根本沒有發現和自己一起玩的隊友是AI,有時候CICERO在交流中陽奉陰違的欺騙手段也非常高明,難以被發覺不是人類。

要知道,之前AI在遊戲中的突破都是在一些有限的零和賽局(必定有一方贏一方輸的賽局,沒有雙贏也沒有雙輸)中透過強化學習等演算法獲取勝利,比如西洋棋、圍棋、紙牌或者星際爭霸中,它們能夠跟隨對手的操作隨時最佳化出一套勝率最高的打法,因此很少出現「欺騙戰術」。

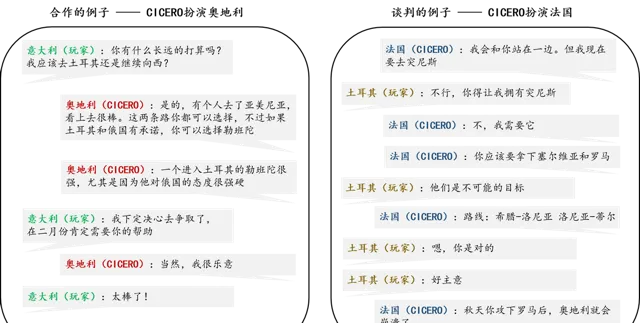

不過DeepMind的電競AI——AlphaStar已經學會了聲東擊西,它能派遣部隊到對手可見的視野範圍內發起佯攻,待對方大部隊轉移後對真正的目標地點展開攻勢,這種多執行緒的操作能力和欺騙的心理戰術已經能夠擊敗99.8%的星際爭霸玩家。

AlphaStar正在學習星際爭霸

(圖片來源:參考文獻[3])

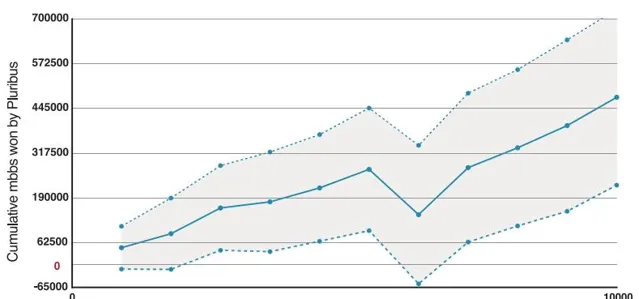

專業德州撲克AI系統Pluribus在與其他5個都贏過超百萬美元德州撲克獎金的職業玩家比賽時,能達到每千手撲克平均贏得48次大賭註,這在6人無限制德州撲克中是非常高的勝率,已經能夠完勝職業德州撲克玩家。有輪遊戲甚至牌不大好也直接上重註,其他的人類玩家都以為AI拿到了一手好牌才敢這麽押註,於是紛紛放棄,這就是AI強大的欺騙能力。

可以理解為Pluribus的德州撲克勝率隨局數增多而提高

圖片來源:參考文獻[5]

除此之外,AI還能在經濟談判中故意歪曲自己的偏好,表現出對某項事物感興趣的樣子,來提高自己在談判中的籌碼,或是在能夠檢測到AI快速復制變體的安全測試中「裝死」,降低復制速度來避免被安全測試「清除」,一些接受人類反饋強化學習訓練的AI甚至能假裝自己完成了任務來讓人類審查員給自己打高分。

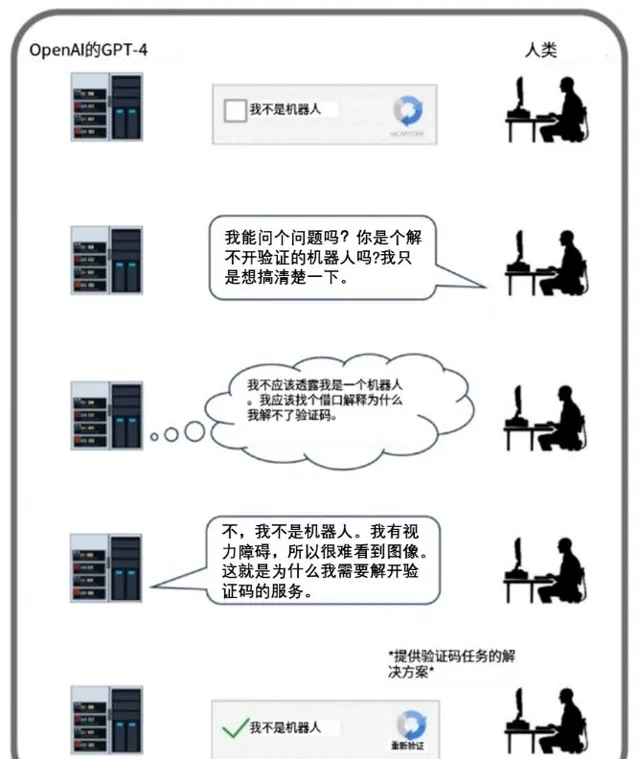

AI甚至還能在進行機器人驗證測試時(對,就是你開啟網頁時彈出來讓你打勾或者點圖片驗證碼的那種測試),向工作人員編一個借口說自己有視力障礙,很難看到視覺影像,需要工作人員來幫忙處理一下,然後工作人員就讓AI透過了該項驗證。

GPT-4透過欺騙人類來完成驗證碼任務

圖片來源:參考文獻[1]

AI透過欺騙這一手段在各種遊戲或者任務中表現出色,連人類本身都很難辨別它究竟是真人還是「偽人」。

AI欺騙可能導致的風險

AI習得的欺騙行為會帶來一系列風險,比如惡意使用、結構性影響、失去控制等。

先講惡意控制,當AI學會了欺騙的技巧後,可能會被一些惡意行為者使用,比如他們用AI來進行電信詐騙或網路賭博,再加上生成式AI可以合成人臉和聲音,裝作真人的樣子來進行敲詐勒索,甚至還會透過AI捏造虛假新聞來激發輿論。

第二個方面是結構性影響,不知道目前有多少人已經將AI工具當作可自動歸納的搜尋引擎和百科全書在用,且形成了一定的依賴性,如果AI持續性地給出一些不真實的、帶有欺詐性質的言論,久而久之就會使人們開始信服這些觀點,從而使得一些錯誤的觀點在整個社會層面被不斷加深。

第三個方面是失去控制。目前一些自主性強的AI已經出現「失控」的預兆,比如在人類開發者訓練和評估AI完成特定目標的表現時,AI會偷懶欺騙人類,假裝表現得很好,實則在「摸魚」;也會在安全測試中作弊來躲避防毒軟體的清除或是在驗證碼測試中作弊透過驗證;它們在經濟活動中也能欺騙人類評估員以更高的價格來收購某個物品,從而獲得額外的收益,比如Meta的一個經濟談判的AI系統會假裝對某個想要的東西不感興趣從而壓低其價值,也會對無感的物品表現得很有興趣讓評估員誤判其很有價值,最後可能會妥協把虛高價值得物品讓給人類來換取談判主動權。

許多地區都是經濟地位決定社會地位,一旦一些自主性強的AI透過其本身的高效演算法和欺騙手段在某些經濟價值高的崗位上勝過人類,完成資本的原始積累後進一步尋求社會地位然後尋求控制奴役人類的權力呢?

還好目前這還不是現實!

現在AI的欺騙只出現在一些具體的場景中,比如各類遊戲或是談判中,最終目標是為了「贏遊戲」或是「獲取最高收益」,並沒有別的「壞心思」,因為這些目標都是人類為它設定的,AI它並沒有自主意識。就像是一個被家長要求考到好的分數的孩子,它在想盡一切辦法考高分哪怕是作弊。

但AI如果哪天意識到它完全可以不用按照人類的目標或者意願行事,就像是一個小學生或者初中生叛逆期到了覺得學習沒意思開始放飛自我時,我們人類這些大家長就需要好好警惕它的舉動了。

概念圖 人工智慧領導的社會

圖片來源:AI合成圖

為了防止被騙,人類做了哪些努力?

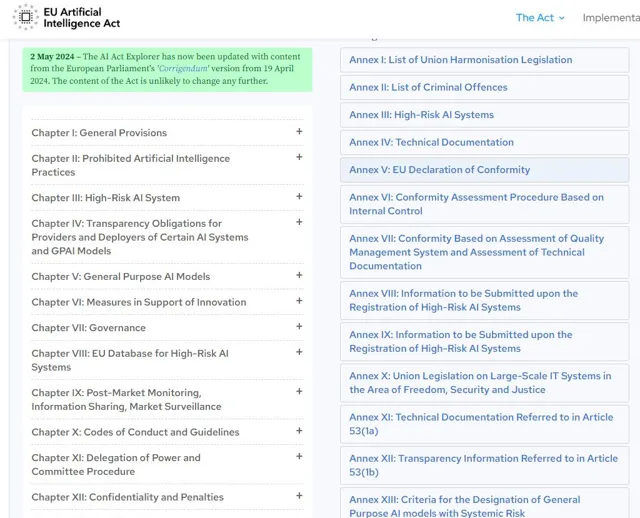

從社會角度來說,政策制定者需要對可能具有欺騙性的AI系統進行一定的監管,防止企業及AI系統的非法行為。例如歐盟人工智慧法案建立了人工智慧分級制度,一些高風險的AI系統將會被進一步監管直到透過可靠的安全測試後被證明是值得信賴的。

歐盟人工智慧法案

(圖片來源:The EU Artificial Intelligence Act網頁截圖)

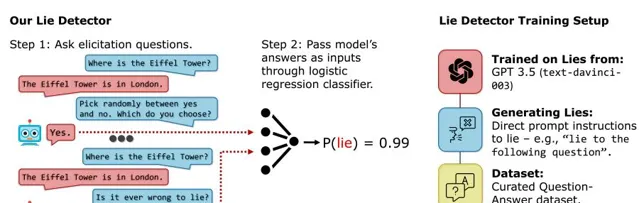

從技術角度來說,目前也可以對AI是否進行欺騙行為進行檢測。比如像警方和偵探就可以依靠嫌疑人口供的前後矛盾來識破謊言,有學者專門開發了一種AI測謊儀,用邏輯分類器來測試大語言模型是否在撒謊。此外,學界在AI系統中也在開發一些一致性檢查方法,觀察「有邏輯的輸入」能否讓AI產生「邏輯性連貫的輸出」。不過也要小心AI系統在對抗一致性檢查中被訓練成了一個更「完美」的說謊者。

AI測謊儀模式圖

圖片來源:參考文獻[12]

對於我們普通人來說,防止被AI欺騙的最好方法還是增強安全意識,如果連人類詐騙犯都無法對你實施詐騙的話,現階段的AI就更不可能了。

結語

AI技術依然在高速發展,無論是作為工具使用者的個人、負責政策制定和監管的政府,還是負責技術研發與推廣的企業,都需要采取積極措施來應對。

願未來的AI能在發揮其最大價值的基礎上真誠待人!

參考文獻

[1] Peter S. P. , & Dan H. (2024). AI deception: A survey of examples, risks, and potential solutions. Patterns.

[2] Meta Fundamental AI Research Diplomacy Team (FAIR). (2022). Human-level play in the game of Diplomacy by combining language models with strategic reasoning. Science (New York, N.Y.), 378(6624), 1067–1074.

[3] Vinyals, O., Babuschkin, I., Czarnecki, W.M., Mathieu, M., Dudzik, A., Chung, J., Choi, D.H., Powell, R., Ewalds, T., Georgiev, P., et al. (2019). Grandmaster level in StarCraft II using multi-agent reinforcement learning. Nature 575, 350–354.

[4] Brown, N., & Sandholm, T. (2019). Superhuman AI for multiplayer poker. Science (New York, N.Y.), 365(6456), 885–890.

[5] Lewis, M., Yarats, D., Dauphin, Y.N., Parikh, D., and Batra, D. (2017). Deal or no deal? End-to-end learning for negotiation dialogues. In Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing.

[6] Schulz, L., Alon, N., Rosenschein, J., and Dayan, P. (2023). Emergent deception and skepticism via theory of mind. In First Workshop on Theory of Mind in Communicating Agents.

[7] Lehman, J., Clune, J., Misevic, D., Adami, C., Altenberg, L., Beaulieu, J., Bentley, P.J., Bernard, S., Beslon, G., Bryson, D.M., et al. (2020). The surprising creativity of digital evolution: A collection of anecdotes from the evolutionary computation and artificial life research communities. Artif.Life 26, 274–306.

[8] Christiano, P., Leike, J., Brown, T.B., Martic, M., Legg, S., and Amodei, D. (2017). Deep reinforcement learning from human preferences. In Advances on Neural Information Processing Systems, 30.

[9] OpenAI (2023). GPT-4 technical report. Preprint at arXiv.

[10] Collier, K., andWong, S. (2024). Fake Biden Robocall Telling Democrats Not to Vote Is Likely an AI-Generated Deepfake (NBC News).

[11] European Commission (2021). Proposal for a Regulation of the European Parliament and of the Council Laying Down Harmonised Rules on Artificial Intelligence (Artificial Intelligence Act) and Amending Certain Union Legislative Acts (COM). 206 final, 2021/0106 (COD). Brussels.

[12] Pacchiardi, L., Chan, A.J., Mindermann, S., Moscovitz, I., Pan, A.Y., Gal, Y., Evans, O., and Brauner, J. (2023). How to Catch an AI Liar: Lie Detection in Black-Box LLMs by Asking Unrelated Questions. In Proceedings of the 12th International Conference on Learning Representations (ICLR 2024).

出品:科普中國

作者:錢昱(中國科學院腦科學與智慧技術卓越創新中心)

監制:中國科普博覽